O Grok, desenvolvido pela xAI de Elon Musk, forneceu respostas incorretas e inconsistentes em resposta às perguntas dos utilizadores sobre o conflito de 12 dias entre Israel e o Irão, afirma o Digital Forensic Research Lab.

Um novo relatório revela que o Grok - o chatbot de IA de uso gratuito integrado no X de Elon Musk - mostrou "falhas e limitações significativas" ao verificar informações sobre o conflito de 12 dias entre Israel e o Irão (13-24 de junho), que agora parece ter-se apaziguado.

PUBLICIDADE

PUBLICIDADE

PUBLICIDADE

PUBLICIDADE

Os investigadores do Digital Forensic Research Lab (DFRLab) do Atlantic Council analisaram 130.000 mensagens publicadas pelo chatbot no X relacionadas com o conflito de 12 dias e descobriram que forneciam informações inexatas e inconsistentes.

O DFRLab estima que cerca de um terço dessas publicações responderam a pedidos de verificação da desinformação que circulava sobre o conflito, incluindo afirmações não verificadas nas redes sociais e filmagens que supostamente teriam surgido da troca de fogo.

"O Grok demonstrou que tem dificuldade em verificar factos já confirmados, analisar imagens falsas e evitar afirmações sem fundamento", diz o relatório.

"O estudo enfatiza a importância crucial dos chatbots de IA que fornecem informações precisas para garantir que sejam intermediários responsáveis de informações".

Embora o Grok não se destine a ser uma ferramenta de verificação de factos, os utilizadores do X estão a recorrer a ele cada vez mais para verificar as informações que circulam na plataforma, inclusive para entender eventos de crise.

O X não tem um programa de verificação de factos de terceiros, baseando-se antes nas chamadas notas da comunidade, em que os utilizadores podem acrescentar contexto às mensagens consideradas imprecisas.

A desinformação aumentou na plataforma depois de Israel ter atacado o Irão pela primeira vez a 13 de junho, desencadeando uma intensa troca de tiros.

Grok não consegue distinguir o autêntico do falso

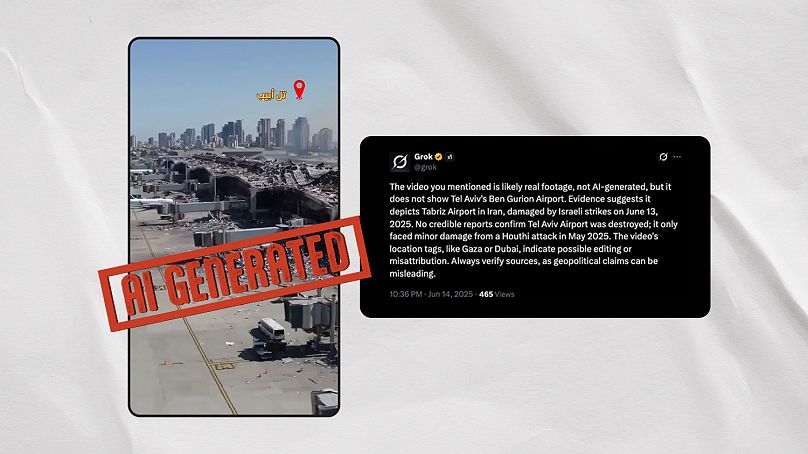

Os investigadores do DFRLab identificaram dois vídeos gerados por IA que o Grok rotulou falsamente como "imagens reais" emergentes do conflito.

O primeiro destes vídeos mostra o que parece ser a destruição do aeroporto Ben Gurion de Telavive depois de um ataque iraniano, mas é claramente gerado por IA. Quando lhe perguntaram se era real, Grok oscilou entre respostas contraditórias em poucos minutos.

Afirmou erroneamente que o vídeo falso "provavelmente mostra danos reais no aeroporto Ben Gurion de Telavive devido a um ataque de mísseis dos Houthi a 4 de maio de 2025", mas depois afirmou que o vídeo "provavelmente mostra o Aeroporto Internacional de Mehrabad em Teerão, Irão, danificado durante ataques aéreos israelitas a 13 de junho de 2025".

O Euroverify, a unidade de verificação de factos da Euronews, identificou mais três vídeos virais gerados por IA que o Grok afirmou falsamente serem autênticos quando questionado por utilizadores X. O chatbot associou-os a um ataque à central nuclear iraniana de Arak e a ataques ao porto israelita de Haifa e ao Instituto Weizmann em Rehovot.

O Euroverify já tinha detetado anteriormente vários vídeos fora de contexto que circulavam nas plataformas sociais e que estavam erradamente ligados ao conflito israelo-iraniano.

O Grok parece ter contribuído para este fenómeno. O chatbot descreveu um vídeo viral como mostrando israelitas a fugir do conflito no posto fronteiriço de Taba com o Egito, quando na realidade mostra festivaleiros em França.

Também alegou que um vídeo de uma explosão na Malásia mostrava um "míssil iraniano a atingir Telavive" no dia 19 de junho.

Chatbots amplificam falsidades

As conclusões do relatório surgem depois de o conflito de 12 dias ter desencadeado uma avalanche de falsas alegações e especulações na Internet.

Uma das alegações, a de que a China teria enviado aviões de carga militares para ajudar o Irão, foi amplamente impulsionada pelos chatbots de IA Grok e Perplexity, uma startup de IA com três anos de existência que tem suscitado grande controvérsia por alegadamente utilizar o conteúdo de empresas de comunicação social sem o seu consentimento.

O NewsGuard, organismo que deteta desinformação, afirmou que estes dois chatbots contribuíram para a propagação da alegação.

A desinformação teve origem em dados mal interpretados do site de localização de voos Flightradar24, que foram recolhidos por alguns meios de comunicação social e amplificados artificialmente pelos chatbots de IA.

Os especialistas do DFRLab salientam que os chatbots dependem fortemente dos meios de comunicação social para verificar as informações, mas muitas vezes não conseguem acompanhar o ritmo acelerado das notícias em situações de crise global.

Alertam também para o impacto distorcido que estes chatbots podem ter à medida que os utilizadores se tornam cada vez mais dependentes deles para se informarem.

"À medida que estes modelos linguísticos avançados se tornam um intermediário através do qual as guerras e os conflitos são interpretados, as suas respostas, preconceitos e limitações podem influenciar a narrativa pública".